L'intelligence artificielle a connu un essor considérable ces derniers temps. Tout le monde est tellement enthousiasmé par cette technologie qu'il ne se rend même pas compte des risques qui pourraient survenir à l'avenir. Les experts en IA tirent actuellement la sonnette d'alarme, avertissant les entreprises qu'elles devraient commencer à s'attaquer aux risques avant qu'il ne soit trop tard.

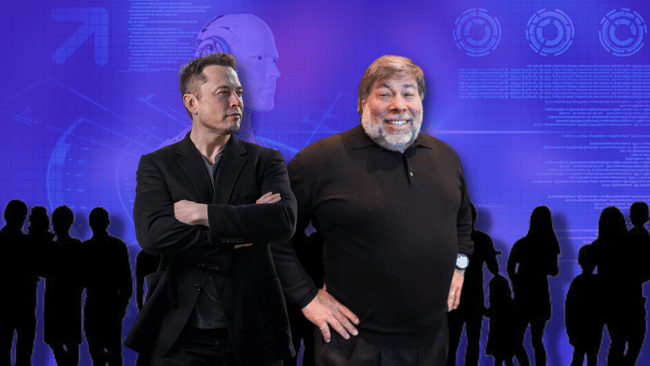

Dans une lettre ouverte récente intitulée "Pause Giant AI Experiments : An Open Letter", des experts en intelligence artificielle (IA) demandent aux entreprises travaillant dans ce domaine d'interrompre temporairement le développement de systèmes d'IA générative. La lettre, signée par plus de 1 000 personnes, dont Elon Musk, Steve Wozniak, Evan Sharp, Craig Peters et Yoshua Bengio, souligne l'incertitude quant à l'impact potentiel futur des résultats de ces développements.

Dans cette lettre, les experts suggèrent une pause de six mois pour élaborer des politiques et des procédures réglementaires permettant de faire progresser la technologie de l'IA en toute sécurité. Cette pause ne devrait s'appliquer qu'à l'entraînement de systèmes d'IA plus puissants que GPT-4, le modèle d'IA générative mis au point par OpenAI. Si l'appel des experts n'est pas entendu, la lettre suggère que les gouvernements imposent un moratoire.

Les entreprises qui investissent dans le développement de l'IA générative et des technologies connexes comprennent des géants tels que Microsoft $MSFT, Alphabet $GOOGL, Alibaba $BABA et Baidu $BIDU. La lettre des experts appelle à des protocoles de sécurité et à l'assurance d'un impact positif et d'une gestion des risques. Le résultat de cette lettre pourrait amener les entreprises à cesser leurs activités et à formuler de nouvelles politiques, ou au moins à réfléchir aux impacts potentiels et à prendre les mesures nécessaires.

Le GPT-4, déclencheur de problèmes potentiels

Le GPT-4, récemment introduit, a impressionné les utilisateurs par ses capacités de conversation, d'écriture de chansons et de résumé de longs documents. La réaction à ce modèle a conduit des concurrents tels qu'Alphabet Inc. à accélérer le développement de grands modèles de langage similaires. Toutefois, les experts en IA appellent à un ralentissement du développement jusqu'à ce que nous comprenions mieux les implications et les dommages potentiels pour la société.

Le Future of Life Institute, une organisation à but non lucratif financée principalement par la Fondation Musk, le groupe Founders Pledge basé à Londres et la Silicon Valley Community Foundation, qui a publié une lettre ouverte, estime que les systèmes d'IA puissants ne devraient être développés que lorsque nous sommes certains que leurs effets seront positifs et que leurs risques seront gérables. L'organisation demande également la mise en place d'un organisme de réglementation chargé de veiller à ce que le développement de l'IA serve l'intérêt public.

Elon Musk, cofondateur d'OpenAI et l'un des experts signataires de la lettre, est connu pour ses mises en garde contre les risques potentiels associés au développement de l'IA. Il estime qu'il est essentiel d'établir des protocoles de sécurité partagés, élaborés par des experts indépendants, et invite les développeurs à collaborer avec les décideurs politiques en matière de gouvernance.

Le directeur exécutif d'OpenAI, Sam Altman, et les PDG d'Alphabet et de Microsoft, Sundar Pichai et Satya Nadella, ne figurent pas parmi les signataires de la lettre ouverte. Néanmoins, la lettre représente une étape importante vers l'ouverture d'une discussion sur l'avenir de l'IA et les risques potentiels qu'elle pose.

Implications possibles de la lettre

La lettre peut avoir plusieurs conséquences. L'une d'entre elles est que les entreprises et les instituts de recherche impliqués dans le développement de l'IA pourraient temporairement interrompre leurs activités et repenser leurs pratiques. Ce scénario permettrait aux experts et aux régulateurs d'examiner les développements réalisés à ce jour et de prendre les mesures nécessaires pour garantir la sécurité et la durabilité dans le domaine de l'IA.

Par ailleurs, la lettre pourrait conduire à une plus grande prise de conscience des risques potentiels liés au développement de l'IA et de la nécessité d'établir des protocoles de sécurité et des procédures réglementaires. Les entreprises pourraient ainsi se concentrer davantage sur la création de systèmes d'IA plus sûrs et plus éthiques ayant un impact positif sur la société.

Enfin, la lettre pourrait inciter les gouvernements et les organisations internationales à envisager l'introduction de mesures réglementaires et de moratoires pour le développement de l'IA. Cela permettrait de s'assurer que le développement de l'IA est mené conformément aux meilleurs intérêts de la société et géré de manière à minimiser les impacts négatifs potentiels.

Quelle que soit l'issue de la lettre ouverte, il est clair que le débat sur la sécurité et l'éthique du développement de l'IA est de plus en plus urgent. Alors que les systèmes d'IA tels que le GPT-4 deviennent de plus en plus omniprésents dans la vie quotidienne, il est nécessaire de se concentrer sur la manière dont ces technologies peuvent être utilisées pour le bien de la société sans compromettre la vie privée, la sécurité ou les intérêts des individus.

Un exemple qui montre comment les systèmes d'IA peuvent être utilisés pour le bien public est l'utilisation des TPG-4 pour résoudre des problèmes environnementaux, sanitaires ou économiques. D'un autre côté, il est important d'envisager les risques possibles, tels que l'utilisation abusive de la technologie pour diffuser de fausses informations, manipuler l'opinion publique ou accroître l'inégalité d'accès à la technologie.

La lettre ouverte "Pause Giant AI Experiments" est un appel à la réflexion sur la voie que prendra le développement de l'IA. Il reste à savoir si les experts, les entreprises et les gouvernements parviendront à un consensus. Toutefois, il est important que les scientifiques, les chefs d'entreprise et les décideurs politiques travaillent ensemble pour trouver des moyens de sécuriser et de réglementer le développement de l'IA dans l'intérêt de l'humanité.

AVERTISSEMENT : Je ne suis pas un conseiller financier et ce document ne constitue pas une recommandation financière ou d'investissement. Le contenu de ce document est purement informatif.